Co ujawniona dokumentacja deweloperska mówi o ewolucji Xbox One

Opowieść o miesiącach zakulisowych prac, Kinekcie i nowym kierunku, jaki Microsoft wyznaczył swojej konsoli.

Niedawny „wyciek” narzędzi deweloperskich dla Xbox One - włącznie z dokumentacją towarzyszącą oprogramowaniu - pozwolił nam bliżej przyjrzeć się procesowi tworzenia i rozwoju najnowszej konsoli Microsoftu. To z tego przecieku dowiedzieliśmy się o udostępnieniu deweloperom siódmego rdzenia CPU, ale dokumenty zawierają dużo więcej fascynujących informacji. Na dobrą sprawę zawierają bowiem dokładną rozpiskę zmian, jakie wprowadzono w oprogramowaniu od czasu pierwszych devkitów przekazanych deweloperom w kwietniu 2012 roku, aż po udoskonalenia dostępne w niedawnej aktualizacji z listopada 2014.

I choć nie ma miejsca i czasu, by przeanalizować każdą najdrobniejszą optymalizację API (interfejsu programistycznego aplikacji) wprowadzoną w okresie tych 19 miesięcy, szczęśliwie ktoś już przygotował podsumowanie. W sekcji „Co nowego” („What's New”) na samym początku dokumentu znajdziemy nie tylko wypunktowane aktualizacje, ale też odnośniki do adekwatnych działów, wskazujące najważniejsze zmiany. Z nich zaś możemy wywnioskować, co było na początku, co zmieniono i czego możemy się spodziewać w przyszłości.

Swoją drogą, równie fascynujące jest obserwować, jak zmieniał się punkt ciężkości i kierunek, w jakim zmierzała konsola, gdy podjęto decyzję o usunięciu sensora Kinect z podstawowego zestawu - gdy cały wysiłek włożony w opracowanie opartego na gestach interfejsu NUI (natural user interface) został wyrzucony do kosza na rzecz zwiększenia wydajności GPU i optymalizacji. Do tej pory część zasobów konsoli była zarezerwowana dla Kinecta.

Przy okazji dowiedzieliśmy się, że Microsoft świetnie zdawał sobie sprawę - i to jeszcze przed premierą konsoli - z niedostatków zastosowanego GPU. Największą niespodzianką - pomijając wieści o uwolnieniu siódmego rdzenia CPU - okazała się informacja o istnieniu dwóch odrębnych sterowników graficznych dla Radeona. Co prawda zdawaliśmy sobie sprawę z istnienia opracowanego przez Microsoft sterownika mono-driver służącego optymalizacji wydajności sprzętu, za to nowością jest informacja o user-mode driver (UMD, sterownik trybu użytkownika) - o nim wspomnę w artykule jeszcze nie raz.

Źródła bliskie Microsoftowi potwierdzają, że ten opracowany z myślą o Xbox One sterownik miał na celu ułatwienie procesu usuwania błędów i możliwie najszybsze włączenie kodu na konsoli, nawet kosztem wydajności. Ale po kolei.

Kwiecień 2012 - luty 2013: sprzęt wersji alpha

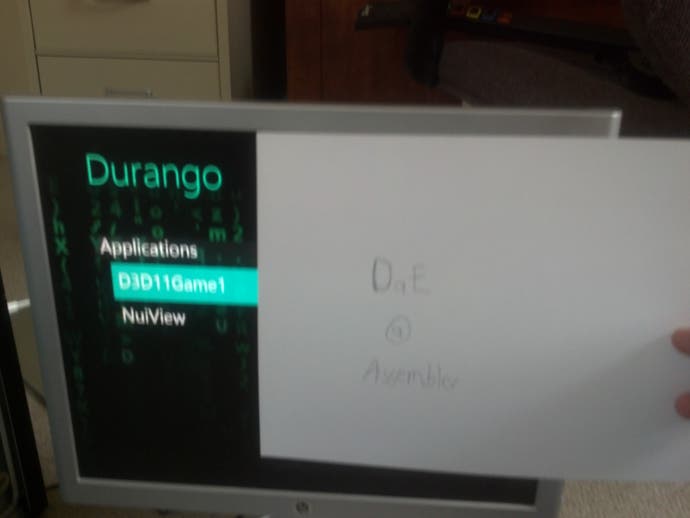

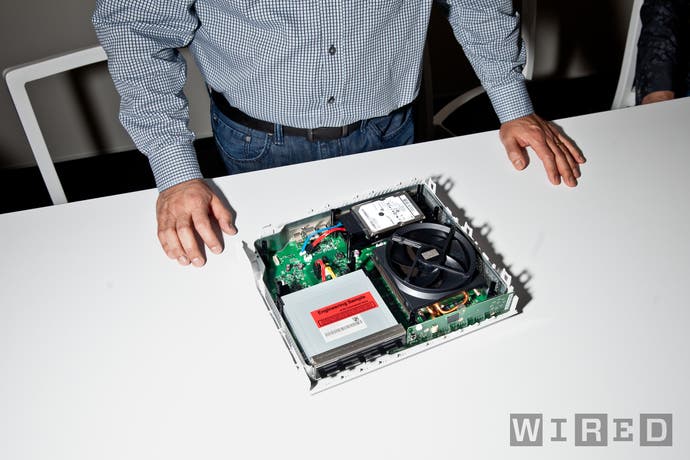

W okresie, gdy pierwsze devkity nowej konsoli Microsoftu trafiały w ręce deweloperów, Xbox One jako taki nie istniał - sprzęt nosił oznaczenie kodowe „Durango” (tak samo, jak stan w Meksyku, tak gwoli ciekawostki). Swoją drogą, nie miał też ustalonej formy - deweloperzy pracowali na całkiem zwyczajnych pecetach, z grubsza odpowiadających specyfikacją przyszłej konsoli. W posiadanie takiego sprzętu, prawdopodobnie za pośrednictwem portalu producenta, wszedł haker SuperDAE, który następnie wystawił devkit na sprzedaż na eBayu. Wtedy też poznaliśmy jego ogólną specyfikację i dowiedzieliśmy się, że Durango oparto na oferujących niewielką moc 64-bitowych rdzeniach x86, z komponentami kompatybilnymi z DirectX 11.

Do tego czasu inżynierowie Microsoftu zdążyli już opracować APU (zintegrowany układ scalony) zawierający CPU, GPU, silniki Move Engine i ESRAM, ale sprzętowi dopiero nadawano ostateczny kształt w laboratoriach firmy. Równolegle na devkitach w wersji alpha trwały prace nad oprogramowaniem. Jedno wiemy na pewno: w tym okresie programiści skupiali się jeszcze na funkcjach multimedialnych - łączeniu z innymi urządzeniami przy wykorzystaniu aplikacji SmartGlass, wykorzystującym Kinect 2.0 interfejsie NUI i mediach jako takich.

Natural User Interface: Pamiętacie ideę „centrum domowej rozrywki” i to, jak duży nacisk Microsoft kładł na Kinect i telewizję? W początkowym okresie prac nad oprogramowaniem, tak mocno krytykowany czujnik ruchu stanowił główny element systemu, a deweloperzy uczyli się, ile można wycisnąć z drugiej generacji sprzętu. W pierwotnym oprogramowaniu Xbox One znajdziemy interesujące narzędzia, umożliwiające na przykład porównanie obrazu uzyskanego za pośrednictwem pierwszego Kinecta z efektami, które pozwala uzyskać czujnik Durango w wersji pre-alpha. W tym okresie konfiguracja sprzętu była jeszcze dość płynna, a deweloperom udostępniono wyłącznie obraz w podczerwieni i dane głębi.

Przeglądając zmiany, jakie pojawiły się w kolejnych aktualizacjach, zauważymy bogaty katalog modyfikacji nowego sensora, dokonane za pośrednictwem API NUI 2.0. Zaawansowane funkcje śledzenia szkieletu, detekcja układu dłoni, detekcja wyrazu twarzy, usługi identyfikacyjne i nowy system rozpoznawania mowy - wszystkie te modyfikacje (i wiele innych) pojawiały się w wraz z aktualizacją z sierpnia 2012 roku. Nie ulega wątpliwości, że Kinect 2.0 odgrywał ogromną rolę w planach dotyczących Xbox One, a w ręce deweloperów oddano liczne narzędzia, pozwalające lepiej wykorzystać czujnik ruchu. Co ciekawe, w 2012 roku Microsoft zdawał sobie sprawę z faktu, że zainteresowanie pierwszym Kinectem szybko przygasa, ale nie wpłynęło to decyzję o wstrzymaniu prac nad nowym sensorem. Być może włodarzom firmy wydawało się, że za drugim razem trafią w dziesiątkę, ale równie prawdopodobne jest to, że do tego czasu strategiczne decyzje dotyczące sprzętu już podjęto - zwłaszcza te mówiące o stworzeniu „centrum rozrywki przyszłości” - i zmiana kursu po prostu nie wchodziła już w grę.

Grafika: Pierwsze devkity - te dostępne w pecetowych obudowach - wyposażono w karty graficzne od AMD i całkiem zwyczajne sterowniki do DirectX 11. Ale jeszcze w kwietniu 2012 roku Microsoft zaczął rozsyłać do deweloperów skrojone pod Durango sterowniki o ograniczonej funkcjonalności, czyli UMD (user-mode driver). UMD regularnie rozbudowywano o nowe funkcje: kodowanie i rozkodowywanie sygnału wideo, teselację dla D3D 11.1, zmiany operowania shaderami i wiele innych. Do sierpnia UMD całkowicie zastępiło poprzednie sterowniki (dwa miesiące później devkity całkowicie przestaną je wspierać). Nadal oferowano systematyczne aktualizacje, ale sprawy nabrały rozpędu dopiero po wydaniu monolitycznego sterownika dla D3D - wysoce zoptymalizowanego interfejsu GPU, który nieustannie rozwijano i który ostatecznie zastąpił UMD.

Narzędzia deweloperskie: W maju 2012 roku Microsoft udostępnia deweloperom PIX, wysokiej klasy narzędzie do profilowania, które od dawien dawna służyło społeczności twórców skupionych wokół konsol Xbox do analizowania wydajności tworzonego kodu. W wersji podstawowej oprogramowanie jest mocno okrojone, ale PIX szybko zyskuje nowe, ważne funkcjonalności: przeglądarkę zawartości, umożliwiającą wgląd w obiekt docelowy renderowania i bufor głębi, graficzny zapis zapytań GPU, nieustannie rozwijany interfejs użytkownika i możliwość przechwytywania danych z CPU i GPU do dalszej analizy. Do tego dochodzi wsparcie dla zdarzeń zaprogramowanych przez użytkownika i wstępna wersja systemu monitorującego, wykorzystywanego w profilowaniu w czasie rzeczywistym, pozwalająca na bieżąco śledzić wydajność kodu. Na początkowym etapie prac dodano - i zmodyfikowano - również wiele innych narzędzi. Usprawniono kod Visual Studio, dodano nowe szablony, przyspieszono funkcjonalności testowe, zmieniono architekturę i usprawniono metody generowania kodu.

Kontrolery: Od samego początku dostępna jest - w bardzo okrojonej postaci - aplikacja towarzysząca typu companion app, która w sierpniu zyska nazwę: SmartGlass. Niewiele wcześniej wprowadzono obsługę wibracji w triggerach, co sugeruje, że prace nad ogólnym kształtem nowego kontrolera dobiegają końcowi. Z kolei API odpowiedzialne za wprowadzanie danych jest nieustannie modyfikowane.

Dźwięk: Ponieważ nie sfinalizowano jeszcze konstrukcji konsoli, szczegóły dotyczące sprzętu odpowiedzialnego za przetwarzanie dźwięku i towarzyszące mu oprogramowanie schodzą na dalszy plan (Xbox One wyposażono w potężny, dedykowany układ dźwiękowy, bardzo zbliżony do TrueAudio produkcji AMD, wykorzystany w nowszych kartach tego producenta). Podstawowe funkcjonalności są dostępne już na starcie, ale dopiero w sierpniu devkity wyposażono w sprzętową emulację dźwięku, co pozwoliło deweloperom rozpocząć testy kodu.

Styczeń 2013 - sierpień 2013: sprzęt w wersji beta

Wkraczamy w nowy rok, a oficjalna zapowiedź konsoli zbliża się wielkimi krokami. W okolicach lutego devkity mają już postać konsol, które zobaczymy na półkach, włączając w to układy scalone. Niemniej, prace nad ostateczną wersją oprogramowania nadal trwają. Ze względu na swój wygląd - biała obudowa konsoli z czarnymi pasami - devkity zyskują przydomek „zebra”. Chodzą słuchy, że każda konsola ma indywidualny układ, celem ułatwienia identyfikacji źródła potencjalnego przecieku. Ta daleko idąca przezorność może wywołać lekki uśmieszek, biorąc pod uwagę, że do tej pory SuperDAE i serwis VGLeaks opublikowali w zasadzie komplet informacji na temat Durango. Jako ciekawostkę można potraktować fakt, że w dokumentacji, która wyciekła niedawno, znajdziemy również starsze przecieki - niemal słowo w słowo w postaci, jak trafiła do Internetu.

Do marca 2013 roku devkity w ich pierwotnej postaci przestają być obsługiwane, a ich miejsce zajmują Zebry. W przeciągu kolejnych miesięcy również one ustąpią miejsca sklepowej wersji konsoli, którą charakteryzuje nie tylko bardziej konserwatywny wygląd, ale też fakt, że przystosowano je do korzystania z szybszego taktowania CPU i GPU (odpowiednio 1,75 GHz i 853 MHz). Nie ustają też prace nad rozwojem oprogramowania:

„Do maja 2014 roku, gdy ostatecznie zrezygnowano z UMD, Xbox One miał dwa sterowniki dla GPU.”

Nagrywarka: Prace nad tą funkcją musiały trwać od dłuższego czasu. Intrygujące, że w ręce deweloperów oddano ją w marcu 2013, niedługo po ogłoszeniu analogicznej funkcjonalności na PlayStation 4. Możliwość dzielenia się nagraniami z rozgrywki miała zasadnicze znaczenie dla planów zarówno Microsoftu i Sony, i nie było wątpliwości co do tego, że obie konsole będą wykorzystywać do tego celu identyczne podzespoły od AMD.

Grafika: UMD nieustannie ewoluuje, ale w lipcu 2013 roku Microsoft wprowadza próbną wersję monolitycznego sterownika dla Direct 3D (później określany mianem mono-driver). Sterownik miał przebudować funkcje D3D, przystosowując je do potrzeb i możliwości konsoli, a przy okazji wyeliminować zbędne funkcjonalności i zmniejszyć obciążenie. Choć trudno w to uwierzyć, do maja 2014, gdy ostatecznie zrezygnowano z UMD, Xbox One miał dwa sterowniki dla GPU. W przyszłości mono-driver odegra kluczową rolę w optymalizacji gier, ale wersja wykorzystana przy pracy nad tytułami premierowymi znacząco ustępuje sterownikowi, którym dysponujemy dzisiaj. Jeden z działów SDK opatrzono entuzjastycznie brzmiącym nagłówkiem „Koniec z tearingiem” („Tear no more!”), wprowadzając v-sync i wsparcie dla adaptacyjnego v-syncu. Przy okazji dodano obsługę trybu 720p, ale wygląda na to, że chodzi po prostu o zwykłe skalowanie obrazu z 1080p.

Xbox Live: W 2013 roku Xbox One doczekał się wielu nowych funkcjonalności oraz usprawnionego API dla usług Xbox Live, włączając w to obsługę profilów, rankingów i podglądu poczynań innych graczy.

Natural User Interface: Kinect doczekał się kolejnych usprawnień, gdy twórcy konsoli dopięli na ostatni guzik konstrukcję Xboksa One i towarzyszącego mu sensora. Od tego momentu aktualizacje koncentrują się na poprawieniu dokładności urządzenia. Owocuje to systemem rozpoznawania poszczególnych palców, wzajemnego ułożenia stawów, rozpoznawania ułożenia ust i oczu, usprawnieniem odczytu postaci użytkownika w pozycji siedzącej i pochylającej się oraz wieloma innymi funkcjonalnościami, opracowanymi z myślą o interakcji gracza z interfejsem. Z dokumentów można wywnioskować, że komplet opcji został udostępniony dość późno, przez co produkcja tytułów wykorzystujących wyłącznie kamerę była mocno utrudniony - co wyjaśniałoby, dlaczego nawet sam Microsoft nie dostarczył przy premierze konsoli tytułów, które pokazałyby pełen zakres możliwości czujnika ruchu.

Ostatnia aktualizacja przed premierą ma miejsce najprawdopodobniej w sierpniu 2013 - wtedy też wydany zostaje trzeci service pack (QFE3) dla systemu operacyjnego Xbox One. Co ciekawe, w dokumentacji znajdziemy też dział poświęcony przygotowaniu tytułów na start konsoli, w tym zastosowania dynamicznej rozdzielczości ekranu. Tekst czarno na białym mówi, że jeśli deweloper ma trudności z osiągnięciem płynności w docelowej rozdzielczości, to w zależności od obciążenia GPU powinien wziąć po uwagę możliwość obniżenia tej drugiej. Zdumiewające jest to, że Microsoft dostarczył narzędzia ułatwiających realizację tego zadania i dostosowania rozdzielczości już na poziomie pojedynczych klatek. Na razie jedynym tytułem, w którym zastosowano ten system, jest Wolfenstein: The New Order. Nie wiemy jednak, czy deweloper skorzystał z API Microsoftu, czy też silnik id Tech 5 dysponuje własnymi narzędziami. Podejrzewamy, że prawdziwa jest druga opcja, ponieważ tę samą technikę zastosowano w wersji na PS4.

„Ostatnia aktualizacja przed premierą ma miejsce najprawdopodobniej w sierpniu 2013 roku.”

Microsoft wie już, że wiele tytułów (w tym kilka tworzonych przez wewnętrzne studia) zadebiutuje w niższej rozdzielczości. Dokumentacja podkreśla zalety stosowania oprogramowania skalującego, które - jak zauważa producent - sprawuje się nawet lepiej niż analogiczna - i bardzo wydajna - technologia zastosowana w X360. Może i jest w tym sporo prawdy, ale biorąc pod uwagę problemy ze skalowaniem, widoczne w tytułach premierowych (do czołówki zaliczylibyśmy filtr wyostrzający, z którego zrezygnowano na początku 2014 roku) trudno zrozumieć, dlaczego Microsoft określa swoją technologię mianem „wspaniałego skalera”.

Producent wspomina też o użyciu opracowanej przez AMD techniki wygładzania krawędzi EQAA, którą zaimplementowano na kilka miesięcy przed debiutem konsoli - tyle, że nie przypominamy sobie, by któryś z tytułów premierowych z niej korzystał. Napomknięto również o użyciu 4x MSAA w sytuacji, gdy gra korzysta już z wariantu 2x, na co pozwalałyby niskie nakłady GPU (dwie pierwsze części każdego piksela zostają przesunięte do ESRAM-u, a dwa pozostałe do pamięci głównej, do której konsola nie sięga równie często ze względu na dużą kompresję). Pomysł jest ciekawy i niewykluczone, że zastosowano go w Forza Horizon 2 - to jedyny znany nam tytuł klasy AAA na Xbox One, w którym dopatrzyliśmy się 4x MSAA.

Styczeń - listopad 2014 i później

Okres między sierpniem 2013 a lutym 2014 dział „Co nowego” dokumentacji pomija milczeniem. Nie wiemy, czy faktycznie nie aktualizowano wtedy oprogramowania, czy też pominięto jego szczegóły. Początek 2014 roku okazał się bardzo ważny dla Microsoftu - wtedy bowiem firma podjęła próbę wyprostowania błędów popełnionych przy premierze konsoli i odniosła się do różnicy mocy GPU Xbox One i PlayStation 4. Pierwsze wpisy z tego okresu dotyczą przekazania w ręce deweloperów większej kontroli nad zasobami ESRAM-u, który - jak można się domyślać - stał się „wąskim gardłem” wielu tytułów startowych.

Grafika: Przez kilka kolejnych miesięcy pojawia się wiele aktualizacji sterownika D3D. W marcu oprogramowanie wzbogacono o sprzętowe kodowanie i dekodowanie sygnału wideo i wsparcie dla asynchronicznych obliczeń GPU. Do maja znika wsparcie dla UMD - zastąpi je mono-driver, co wyjaśnia przynajmniej po części lepszą wydajność tytułów wydawanych od drugiego kwartału 2014 roku. Praca włożona w optymalizację sterownika przynosi owoce, a Microsoft niemal co miesiąc informuje o poprawie wydajności GPU, włączając w to czerwcowy, zdumiewający skok wydajności w kewstii liczby obiektów renderowanych jednocześnie na ekranie.

Usprawnienia GPU to pokłosie przesunięcia zasobów zarezerwowanych wcześniej dla Kinecta - czerwcowy XDK i jego znaczenie dla zasobów konsoli są świetnie udokumentowane. Co więcej, tytuły, które nie korzystają z funkcji czujnika ruchu - systemu rozpoznawania mowy, czujników głębi i podczerwieni - mogą wykorzystać dodatkowy czas rdzenia CPU. Całkowita rezygnacja z komend głosowych pozwala uwolnić dodatkowy 1 GB/s przepustowości i tym samym zwiększyć wydajność GPU.

Usprawnienia oprogramowania skalującego: W kwietniu aktualizacji doczekało się też oprogramowanie skalujące, a deweloperzy dostali w swoje ręce nowe funkcje. Z dokumentacji dowiadujemy się, że twórcy mogą wybrać jedną z siedmiu opcji upscalingu, w tym skalowanie bilinearne, czterokrotny sinc i cztero/sześcio/ośmiokrotne Lanczos, a także zależne od przepustowości sześciokrotne skalowanie Lanczos. Te dodatkowe opcje znacząco poprawiają jakość obrazu generowanego w rozdzielczości poniżej 1080p i być może to za ich sprawą rozmyły się różnice między tytułami w 900p i 1080p, opublikowanymi w drugiej połowie 2014 roku.

Dźwięk: Do maja 2014 roku wprowadzono możliwość odsłuchiwania muzyki w tle podczas korzystania z aplikacji - to funkcja, jakiej do dzisiaj nie dodano na PS4. Udostępniono też sterowanie głośnością aplikacji/chatu za pośrednictwem Kinecta. W czerwcu pojawiają się kolejne usprawnienia na płaszczyźnie współpracy dedykowanego sprzętu audio i CPU, a pamięć wykorzystywaną przez ACP (audio control processor) przesunięto z pamięci cache do uncached, zmniejszając obciążenie CPU. Przy okazji dodano też wsparcie do mikrofonów USB.

„Największe zmiany dotknęły trybu dla wielu graczy.”

Narzędzia deweloperskie: PIX, narzędzie profilowania Microsoftu, jest nieustannie aktualizowane i we wrześniu twórcy otrzymują dostęp do przeglądarki ESRAM-u, która ma zmaksymalizować wydajność tej pamięci. Co ciekawe, w dokumentacji znajdziemy wzmianki o dedykowanej funkcjonalności zrzucania screenów z gry, z której gracze bez wątpienia bardzo by się ucieszyli. W sierpniu Xbox otrzymuje też funkcjonalność PIX znaną z X360 - nagrywanie ostatnich 60 sekund rozgrywki przy jednoczesnym monitorowaniu wydajności gry. W przeciwieństwie do wersji z poprzedniej konsoli Microsoftu, na Xbox One materiał jest nagrywany nieustannie.

Kontrolery i NUI: Większość zmian, które dotknęły Kinecta - pomijając uwolnienie zarezerwowanych dla niego mocy przerobowych - koncentruje się już tylko na łataniu błędów. Co prawda usprawniono między innymi detekcję ruchu, ale wyraźnie widać, że nikt już nie próbuje rozwijać potencjału czujnika. Poprawiono również system wprowadzania komend, określając kiedy dokładnie są one przetwarzane przez kontroler, co z kolei pozwala uzyskać większą kontrolę nad aktualizacjami i zdecydować, które rdzenie powinny przetwarzać dane. Niektóre aplikacje otrzymują też obsługę klawiatury.

Multiplayer: Największe zmiany dotknęły trybu dla wielu graczy. Działy „Multiplayer 2014” i „Multiplayer 2015” opisują dwa różne podejścia do sposobu łączenia graczy. Metoda stosowana dotychczas opiera się na koncepcji „grupy”, gdzie gry wykorzystują systemową metodę zarządzania aktywną grupą użytkowników chcących grać razem. Dokument wspomina o umieszczeniu graczy w „katalogu sesji multiplayer” (MPSD - multiplayer session directory), usłudze operującej w chmurze, w której archiwizowane są sesje multiplayer potrzebne do zarządzania grupą.

W przypadku opcji Multiplayer 2015 Microsoft zrezygnował z tego obostrzenia. W nowej wersji wszystkie funkcjonalności związane z trybem dla wielu graczy są dostępne za pośrednictwem sesji MPSD, z całkowitym pominięciem grupy. Ten zabieg służy przyspieszeniu procesu poprzez wyeliminowanie zbędnych zapytań, które mogą odbić się na płynności sesji. Multiplayer 2015 został udostępniony w wersji testowej jeszcze we wrześniu 2014, ale trudno określić, kiedy zobaczymy tytuły wykorzystujące tę metodę łączenia graczy. Co prawda pojawiły się głosy, że korzysta z niej Halo: The Master Chief Collection, ale jest to raczej wątpliwe, biorąc pod uwagę fakt, że nowa technologia trafiła w ręce deweloperów niedługo przed premierą gry.

Podsumowanie: od centrum rozrywki multimedialnej do kompletnego sprzętu do gier

Digital Foundry cechuje paląca potrzeba lepszego zrozumienia zasad rządzących sprzętem elektronicznym, a wyciek SDK dostarczył nam najwięcej informacji na temat Xbox One od czasów wywiadu z architektami sprzętu, który przeprowadziliśmy jeszcze w październiku 2013 roku. Niektóre szczególiki techniczne nie mają większego znaczenia, inne wprost przeciwnie - ale tak czy inaczej składają się na fascynującą lekturę, pozwalając lepiej zrozumieć, w jakim kierunku Microsoft podążał przez ostatnie 19 pracowitych miesięcy rozwoju konsoli.

To niezwykłe, móc przeanalizować katalog zmian, aktualizacji i dodatkowych funkcjonalności, które w przeważającej mierze wprowadzono kosztem Kinecta. Udostępnienie siódmego rdzenia CPU oraz dodatkowych zasobów GPU, oraz nieustanna optymalizacja mono-drivera pomaga zrozumieć, jakie zakulisowe działania podjął producent sprzętu, by zapewnić swojej konsoli konkurencyjność względem PS4. Ale wielu rzeczy jeszcze nie wiemy - Microsoft zmniejszył rezerwy CPU, ale jak postąpi z trzema gigabajtami pamięci, do których deweloperzy nie mają obecnie dostępu?

Oczywiście, nie powinniśmy analizować tych zmian w oderwaniu od rzeczywistości. Trudno sobie wyobrazić, by Sony również nie zoptymalizowało swojego sprzętu. Co prawda w ręce użytkowników konsoli aktualizacje oprogramowania trafiają wolniej, ale nie wiemy, jak często otrzymują do nich dostęp deweloperzy. Tego typu informacje przebijają się do mediów cienkim strumyczkiem, głównie za pośrednictwem prezentacji z konferencji pokroju GDC/Siggraph). Kto wie, może na modłę Xbox One szczegóły aktualizacji oprogramowania PS4 również pojawią się w Internecie. Tak czy inaczej, jedno jest pewne: gry w 2015 roku powinny wyglądać lepiej - nie tylko ze względu na fakt, że deweloperzy korzystają z bardziej zaawansowanych narzędzi, ale również dlatego, że rozpoczęli prace nad drugą generacją swoich gier na PS4 i Xbox One. Już nie możemy się doczekać, kiedy zobaczymy je w akcji.